La Legge di Huang ha preso il posto della Legge di Moore secondo NVIDIA

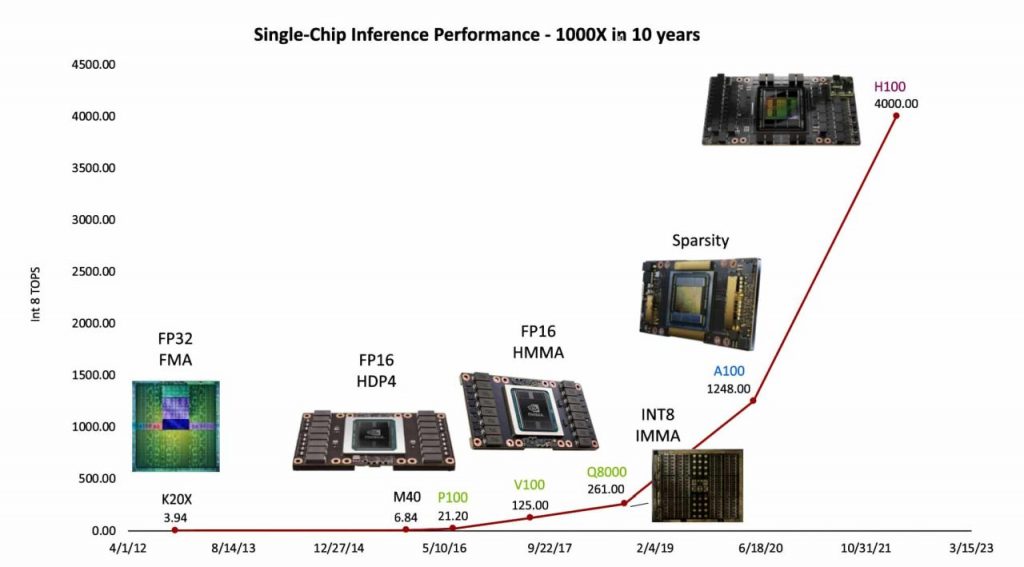

NVIDIA ha parlato di quella che ha definito “Legge di Huang”: nell’ultimo decennio le prestazioni nell’intelligenza artificiale delle GPU NVIDIA sono cresciute di 1000 volte, di cui solo una piccola parte si deve ai dettami della Legge di Moore.

Da anni si dibatte della validità della Legge di Moore, tra chi la giudica moribonda, morta o in piena salute a fronte di una miniaturizzazione dei transistor che sta incontrando sempre più ostacoli. In qualunque modo la si veda, il mondo dell’informatica e della progettazione di chip è al principio di una stagione di forti cambiamenti e forse inquadrarlo con i modelli del passato è semplicemente sbagliato.

Il Chief Scientist di NVIDIA, Bill Dally, ha provato a descrivere il cambiamento epocale che sta vivendo il settore durante un recente keynote. Un discorso che sul blog di NVIDIA è stato ribattezzato “Legge di Huang“, rifacendosi non solo al cofondatore e CEO della società, ma anche a un appellativo coniato da IEEE Spectrum nel 2018 e poi fatto proprio dal Wall Street Journal.

Secondo Dally, “ogni nuovo processore richiede ingegnosità e impegno per inventare e convalidare ingredienti freschi“: parole che non vogliono dire altro che è la progettazione (non solo dell’hardware, ma anche di ciò che lo guida) a portare allo sviluppo di chip sempre più innovativi e potenti, diversamente da quanto avvenuto in passato, quando gli ingegneri si affidavano essenzialmente alla miniaturizzazione.

Dally è al comando di un team di oltre 300 persone all’interno di NVIDIA Research che in 10 anni è riuscito a migliorare di 1000 volte le prestazioni di una singola GPU nell’inferenza dell’intelligenza artificiale. Si tratta di un progresso in risposta all’altrettanto fenomenale boom dei grandi modelli linguistici usati per l’intelligenza artificiale generativa. Secondo Dally è stato proprio il nuovo mercato a scandire il ritmo di sviluppo dell’hardware perché “riteniamo di dover soddisfare questa domanda“.

Dally ha elencato alcuni degli elementi che hanno portato al progresso prestazionale di 1000 volte. Il più grande di tutti, stimato in 16 volte, si lega alla scoperta di modi più semplici per rappresentare i numeri utilizzati dai computer per svolgere i loro calcoli.

L’architettura Hopper con il suo Transformer Engine usa un mix dinamico di calcoli in virgola mobile e interi a 8 e 16 bit, in modo da adattarsi alle esigenze degli odierni modelli di IA generativa. Nel suo discorso Dally ha illustrato sia i miglioramenti prestazionali che i risparmi energetici offerti dal nuovo modo di svolgere calcoli.

A questo si affianca il lavoro del suo team, che è riuscito a ottenere un miglioramento di 12,5 volte creando istruzioni avanzate che dicono alla GPU come organizzare il lavoro. Questi comandi complessi aiutano a eseguire più lavoro con meno energia. Di conseguenza, i computer possono essere “efficienti quanto gli acceleratori dedicati, ma mantenere tutta la programmabilità delle GPU“, ha dichiarato.

L’aggiunta della “Structural Sparsity“, a partire dall’architettura Ampere, permette di non compromettere la precisione del modello IA andando parallelamente ad accelerare i carichi di lavoro di inferenza. La tecnica, secondo Dally, ha portato un ulteriore aumento delle prestazioni di 2 volte e promette ulteriori progressi in futuro.

Nel frattempo NVIDIA è passata, nel corso degli ultimi 10 anni, dalla produzione a 28 nanometri a quella 5 nanometri, ma Dally ha spiegato che il boost ottenuto da questo miglioramento è pari solo a 2,5 volte il totale.

Il Chief Scientist di NVIDIA ritiene che la Legge di Huang continuerà a offrire grandi incrementi prestazionali nonostante i minori vantaggi derivanti dalla Legge di Moore.

Ad esempio, Dally vede diverse opportunità per semplificare ulteriormente il modo in cui i numeri vengono rappresentati, creando una maggiore sparsità nei modelli di intelligenza artificiale e progettando migliori circuiti di memoria e comunicazione. Poiché ogni nuova generazione di chip e sistemi richiede nuove innovazioni, “è un momento divertente per essere un ingegnere informatico“, ha concluso lo scienziato.